구글 웹마스터도구에서 robots.txt 파일을 감지하는 못하는 문제

며칠 전부터 구글 웹마스터도구에서 robots.txt 파일을 제대로 감지하지 못하는 문제가 발생하는 것을 발견했습니다.

문제의 발단은 어떤 블로그에서 차단된 리소스가 많다는 글을 보고 구글 웹마스터도구에서 차단된 리소스 보고서를 확인하여 수정한 후에 발생했습니다.

현재 이 블로그에서 259개 페이지에 차단된 리소스가 있다고 표시됩니다.

자세히 살펴보니 문제의 원인은 robots.txt 파일에 추가한 다음 라인 때문이었습니다.

Disallow: /wp-content/plugins/

특정 플러그인(예: bbPress) 폴더 내의 리소스가 제대로 로드되지 않아서 구글에서 차단된 리소스가 있는 페이지로 인식했습니다.

그래서 robots.txt 파일을 수정한 후에 다시 제출했습니다. 하지만 이때부터 구글에서 robots.txt 파일을 제대로 인식하지 못하고, 특히 새로 올라온 글이 제 시간에 구글에서 크롤링되지 않는 문제까지 겹쳤습니다.

robots.txt 파일은 구글 웹마스터 도구에서 크롤링 > robots.txt 테스터를 클릭하여 테스트해볼 수 있습니다. 저는 HTTP 403 에러가 발생했습니다.

이 문제를 검색해보니 서버에서 구글봇을 차단하는 것과 관련된 것처럼 보였습니다. 하지만 이 블로그가 호스팅 중인 Bluehost에서는 구글봇을 차단하고 있지 않기 때문에, 플러그인이 의심이 되었습니다.

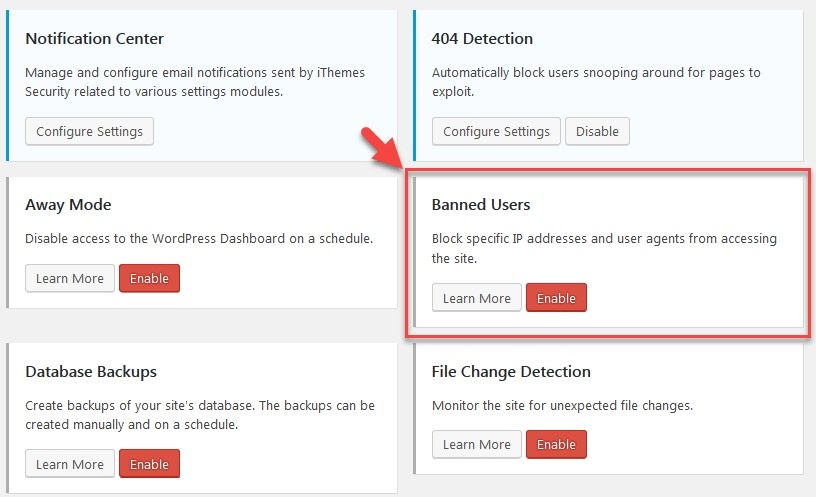

현재 이 블로그에 iThemes Security라는 워드프레스용 보안 플러그인이 설치되어 있습니다. 이 플러그인에는 로그인을 일정 횟수 이상 시도하는 IP를 차단하는 기능이 있습니다.

Banned Users 기능을 비활성화한 후에 robots.txt 테스터를 실행해보니 robots.txt를 정상적으로 감지하네요.ㅎㅎ

이런 문제는 드물 것 같지만 혹시 이와 같은 문제가 발생하면 먼저 웹호스팅 업체와 상의해보고, 웹호스팅 서버에 아무런 문제가 없다면 보안 플러그인을 비활성화한 후에 문제가 해결되는지 테스트해보시기 바랍니다.